Del COBOL a la Agentic AI: Transformando Ciclo de Vida del Software

La Historia Personal Detrás de la Transformación

Cuando a finales de los 1990 llegué a Estocolmo, mi rol fue JCL Coordinator trabajando para la consultora American Management Systems (AMS) en las oficinas del operador de telecomunicaciones Telia. En aquel momento, JCL (Job Control Language), COBOL e IMS eran términos ya veteranos pero todavía sexys en la industria tecnológica. El proceso era lineal, predecible y, sobre todo, controlado. Los diseños técnicos eran prácticamente código en papel que aprobábamos firmándolos con bolígrafo.

Hoy, esos mismos términos evocan una época pasada de trabajos batch y ficheros secuenciales. Paradójicamente, estos términos siguen existiendo y siendo bien pagados por la escasez de expertos. Los que hemos vivido la continua transición tecnológica sabemos que la situación actual representa un cambio más profundo y acelerado siendo la mayor transformación en cómo concebimos, construimos y evolucionamos software desde la llegada de Internet.

La llegada de la Inteligencia Artificial Agéntica está reconfigurando no sólo cómo generamos código, sino cómo lo definimos, probamos, desplegamos, mantenemos y operamos. En mi opinión es un cambio más radical y completo que los anteriores.

En este post, quiero compartir mi perspectiva como profesional que ha visto ya muchos cambios y reflexionar sobre lo que significa para los líderes tecnológicos que debemos navegarla. Mucho tema para un post, quizá requiera secuelas.

Por qué Empezar este Post Hablando de Mainframe

Hablar de esa época no es por nostalgia sino una forma de apreciar la magnitud del cambio actual.

En el mainframe:

- En grandes proyectos programábamos con editor de textos para que nuestros mánagers aprobaran formalmente los cambios en papel antes de llevarlos al código.

- El código se ejecutaba en una máquina cara y compartida.

- Los errores tenían consecuencias operativas inmediatas y costosas.

- La planificación exhaustiva era una necesidad, no una opción.

- El conocimiento era altamente especializado y difícil de transferir

Con la IA agéntica:

- Describimos las necesidades en lenguaje natural para que la IA las interprete.

- La IA genera código que puede ejecutarse en infraestructura elástica y económica

- Los errores se detectan y corrigen en tiempo real, muchas veces de forma autónoma

- La experimentación rápida es la norma, no la excepción

- El conocimiento se democratiza a través de contextos compartidos con la IA

La Era del Mainframe: Cuando el Código se Firmaba en Papel

El Paradigma de la Rigidez Controlada

En mi época de mainframe el ciclo de vida del software operaba bajo principios fundamentalmente diferentes a los actuales:

Características del desarrollo mainframe:

- El ciclo de vida era lineal y rígido: requisitos → desarrollo → pruebas → producción

- Los proyectos se medían en años o, con suerte, en meses. Nunca en semanas.

- Codificábamos la lógica de negocio en COBOL, con ficheros secuenciales o bases de datos IMS.

- El control de la ejecución batch se gestionaba mediante JCL, especificando exactamente qué programa ejecutar, qué dispositivos usar, qué ficheros leer y escribir.

- El control de versiones en entornos era rudimentario y poco automatizado. Los cambios eran planificados con meses de antelación.

- En aquella época el tiempo de máquina era un recurso costoso y limitado por lo que el software tenía que ser meticulosamente planificado y optimizado. Un error en la definición, planificación o ejecución podía ser catastrófico para el proyecto, requiriendo reiniciar el ciclo completo.

Algunos de estos principios se han mantenido posteriormente aunque los avances tecnológicos permitían crear ciclos de vida más rápidos y flexibles.

La Evolución: Del Waterfall al Agile/DevOps

Los Años 90-2000: La Rebelión Contra la Rigidez

El modelo Waterfall dominó el desarrollo durante décadas. Era lento y rígido pero aparentemente eficiente. No podía adaptarse al cambio, por lo que debíamos controlarlo mediante planificación exhaustiva.

Pero eso no era suficientemente ágil para entregar software de calidad que los clientes realmente quisieran, cuando lo necesitaban.

La metodología Ágil fue una respuesta a esta debilidad. Sus defensores se dieron cuenta de que nunca podrían eliminar completamente el riesgo o la incertidumbre de un proyecto. En su lugar, se enfocaron en contener el riesgo a través de desarrollo rápido y validación constante.

Algunas innovaciones de la época Ágil (1990-2010):

- Rapid Application Development (RAD) - James Martin en IBM, 1991: énfasis en proceso y prototipado sobre la planificación excesiva

- Scrum (1995): marcos de trabajo iterativos con sprints, backlogs y equipos autoorganizados

- Extreme Programming (XP) - Kent Beck, 1996: llevar las mejores prácticas al extremo (test-driven development, pair programming)

- Agile Manifesto (2001): 17 desarrolladores en Snowbird, Utah, consolidaron principios que transformarían la industria

Los Años 2010: La Era del Cloud y DevOps

La década de 2010 marcó otro punto de inflexión. Las empresas comenzaron a priorizar la gestión de productos, insights de clientes y experiencia de usuario (UX) sobre la simple producción de “features”.

DevOps emergió cerrando la brecha entre equipos de desarrollo y operaciones. En lugar de escribir código y “lanzarlo” a los administradores de IT, los ingenieros ahora eran responsables de sus despliegues, monitorización y confiabilidad del sistema.

Compañías como Netflix y Spotify se hicieron famosas por sus arquitecturas de microservicios, permitiendo a los equipos trabajar en servicios independientes que escalaban eficientemente.

Avances clave de la época DevOps:

- Integración Continua / Despliegue Continuo (CI/CD)

- Infraestructura como Código (IaC)

- Contenedores y orquestación (Docker, Kubernetes)

- Monitorización y observabilidad en tiempo real

- Cultura de propiedad end-to-end (“You build it, you run it”)

Aunque el Mainframe tardó en adoptar DevOps algunas organizaciones demostraron que era posible en esa dirección. Por ejemplo, Broadcom’s Mainframe Software Division implementó prácticas Agile completas, usando herramientas modernas como Jenkins, GitHub Actions, y Zowe CLI para automatizar CI/CD en mainframes.

Incluso el entorno más tradicional puede transformarse con la mentalidad y herramientas adecuadas.

La Nueva Era: AI-Native Engineering

Qué es AI-Native Engineering

AI-Native Engineering no es simplemente usar IA como herramienta. Es un enfoque que sitúa la IA en el centro del ciclo de vida completo del desarrollo de software, desde la concepción hasta la operación.

Como destaca Gartner, esta transformación requiere:

- Inversión en talento y upskilling de empleados existentes

- Priorización de fuentes diversas de datos para informar decisiones de producto

- Realineación de planificación de negocio en torno a métricas data-driven basadas en resultados

- Inversión en herramientas mejoradas con IA y plataformas integradas

Pero lo más importante: requiere un cambio fundamental en formas de trabajo y roles.. Ni Agile ni DevOps hubieran permitido mejorar la calidad y velocidad de los productos sin incorporar nuevos roles y modelos operativos. Este cambio fundamental es el mayor reto al que nos enfrentamos en este momento para transformar la industria de la tecnología.

El Contexto Económico: $2.6-4.4 Trillones en Juego

Ahora estamos entrando, si no lo hemos hecho ya, en una fase completamente nueva. Esta vez, la velocidad del cambio es sin precedentes.

McKinsey estima que: “la IA generativa podría agregar entre $2.6 trillones y $4.4 trillones a la economía global, fundamentalmente transformando cómo los productos de software son concebidos, desarrollados y llevados al mercado. Este no es un cambio incremental en eficiencia —representa una reimaginación fundamental de todo el proceso de desarrollo de productos.”

En este contexto, además de los sospechosos habituales —Google, AmazonMicrosoft, etc.— aquí se unen los grandes players de la IA —OpenAI, Anthropic, etc.— y una serie de startups que están sabiendo sacar el máximo partido de los LLM para transformar la industria de la tecnología.

Entre estas startups se encuentran empresas como Cognition, que recientemente compró Codeium para adquirir su producto estrella Windsurf. Con esta adquisición, Cognition se convierte en el líder teniendo el que anuncian como primer IDE agéntico (Windsurf) además de su propio agente (Devin). Para hacernos una idea de la magnitud de esta adquisición, OpenAI llegó a hacer una oferta por Codeium de 3.000 millones de dólares y finalmente fue Cognition quien lo adquirió en una operación valorada en 2.400 millones de dólares.

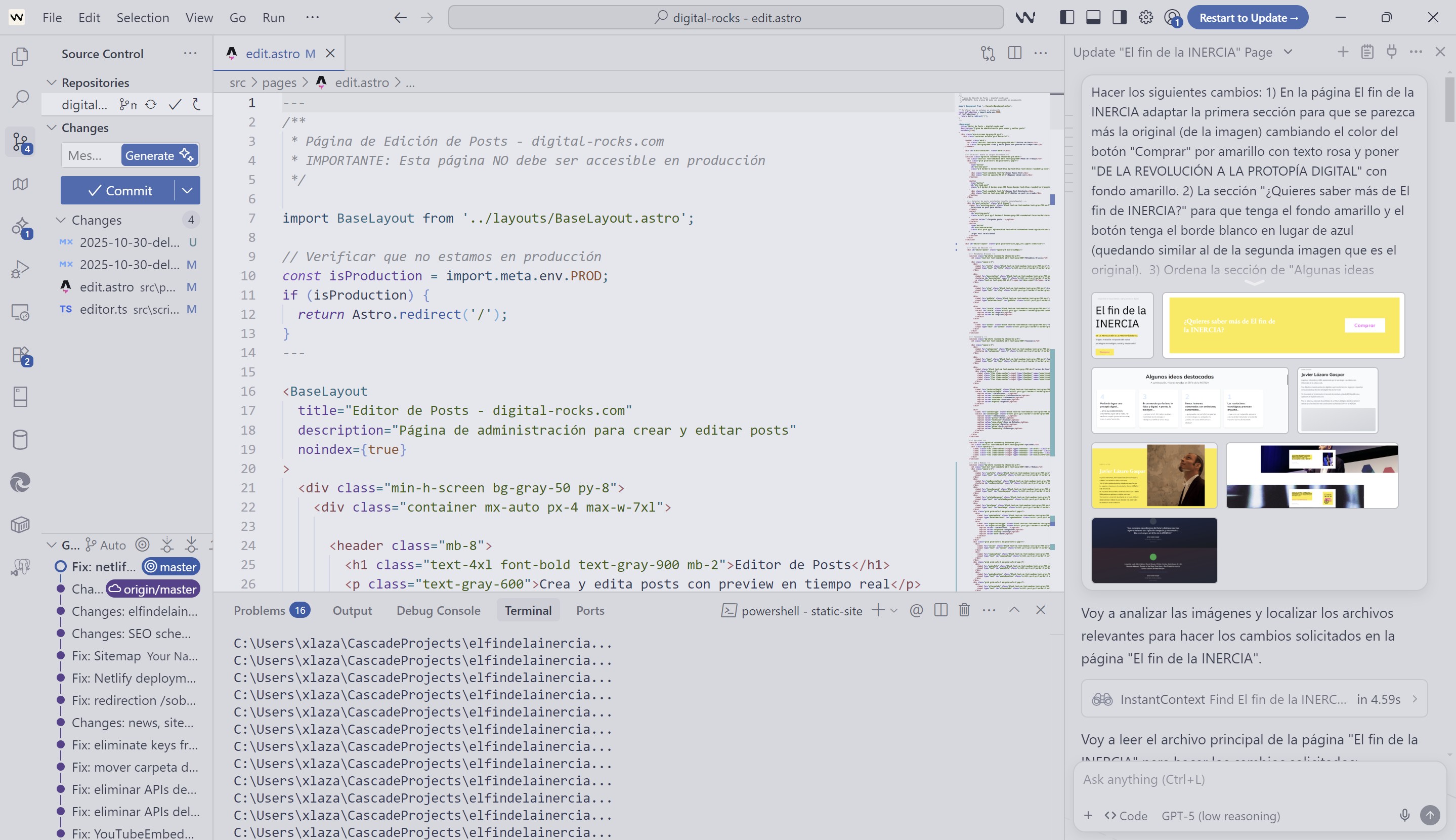

Otro IDE agéntico destacado es Cursor. La compañía fue fundada en 2023 por 3 ex-alumnos del MIT y actualmente está valorada en casi 10.000 millones de dólares y se trata del IDE agéntico de moda entre los equipos de software de empresas tecnológicas como OpenAI, Stripe, Shopify o Spotify entre muchas otras.

En el mundo de agentes IA especializados en ingeniería de software, además de Devin tenemos otros como Blitzy que con una autonomía total tratan de resolver necesidades de desarrollo que antes requerían humanos.

También tienen un rol destacado aquellas plataformas que, sin ser agénticas, habilitan la agilidad en este mundo. Estos productos van más allá del desarrollo y facilitan despliegues de infraestructura por no expertos. Estoy pensando en productos como Vercel, Railway, Netlify, Supabase, etc. Con estos productos facilitan que los propios agentes sean capaces no solo de realizar el desarrollo sino de desplegarlos y mantenerlos.

Goldman está pilotando Devin AI (julio 2025), convirtiéndose en el primer gran banco en usar un ingeniero de software autónomo. Santander no ha tardado en seguir ese mismo camino.

Pero no solo los bancos siguen esa senda, os dejo un vídeo reciente del acuerdo de Ferrovial para emplear Windsurf.

Cuatro Conceptos Fundamentales

Para navegar esta nueva era, necesitamos entender tres conceptos interrelacionados pero distintos:

1. Vibecoding: Conversación Como Interfaz

Vibecoding describe una realidad en la que un desarrollador o experto de dominio describen en lenguaje natural lo que necesita y la IA lo implementa. Un sistema con IA Generativa recibe esa descripción y la transforma en código, componente, módulo o, incluso, aplicación completa ejecutándose.

El trabajo ya no es escribir código sino describir lo que quieres con claridad, dialogar sobre posibles alternativas de solución y validar el resultado o iterar.

Las iteraciones no son de semanas sino de horas o minutos. La dimensión temporal del desarrollo se reduce drásticamente.

2. Agentic AI: Autonomía con Propósito

Agentic AI en desarrollo software se refiere a sistemas de IA que actúan como expertos especializados y autónomos. Pueden ser analistas, arquitectos, desarrolladores, testers, DevOps y cualquier otro rol tradicional.

Estos agentes de IA reciben un objetivo de alto nivel, planifican su propio enfoque, desarrollan, prueban y refactorizan código, lanzan los despliegues, y aprenden y mejoran con el feedback

Gartner predice que para 2027, esta tecnología agéntica estará arraigada en los workflows de ingeniería, y que el 80% de los ingenieros de software tendrán que recapacitarse para adaptarse a roles creados cuando la IA generativa tome funciones de programación más amplias.

La autonomía es todavía limitada pero está creciendo exponencialmente. Cada mes vemos nuevos avances en benchmarks como SWE-bench que miden la capacidad de agentes de IA para resolver issues reales de GitHub.

3. AI-Native Engineering: Reinventando el proceso

AI-Native Engineering es el rediseño completo del SDLC (ciclo de vida del desarrollo de software) con la IA como fundamento arquitectónico, no como herramienta añadida. Esa diferencia es clave porque no implica incorporar IA en los procesos actuales sino reinventar el ciclo de vida del desarrollo software alrededor de las crecientes capacidades de los agentes de IA.

La diferencia clave:

- Vibecoding = colaboración humano-IA para generar código rápidamente.

- Agentic AI = agentes de IA que actúan casi como “desarrollador autónomo”.

- AI-Native Engineering = transformación organizacional, de procesos y herramientas para situar la IA en el centro.

El objetivo no es solo reducir los costes y mejorar el “Time to Market” sino también mejorar la calidad de los productos. Como enfatiza Inbal Shani, CPO y head of R&D en Twilio: “Con la implementación de IA, creo que el cambio más relevante y único será mejoras en la calidad de productos, dada la capacidad de analizar mejor, sintetizar información y hacer recomendaciones.”

4. Context Engineering: Logrando la escala necesaria

Escalar las capacidades anteriores a nivel empresarial requiere las herramientas agénticas pero también dotar a la IA del suficiente conocimiento de la organización y su metodología para que actúe como un miembro del equipo y no como un silo aislado. Esa es la clave para generar software de calidad que pueda ser utilizado en producción y se logra mediante la Ingeniería de Contexto (o “Context Engineering”).

El Impacto Transformador en el SDLC Completo

Aceleración sin Precedentes

No hemos hecho más que arrancar esta transformación y los números son ya impresionantes. Desde hace un año en todas las reuniones con partners hago la misma pregunta: ¿qué impacto está teniendo la introducción de IA en el SDLC?

Sin irme a los más optimistas, yo diría que:

- 30% de aumento en productividad de Product Managers

- 20% de aceleración en time-to-market en un proyecto de 6 meses pudiendo ser mucho más alta si se incorpora la IA no solo en el desarrollo sino también en la definición, arquitectura, pruebas, despliegue y mantenimiento.

- En proyectos menores o MVP de 8-10 semanas, la aceleración puede ser del 60% o más.

Estos datos se aproximan a estudios de analistas como McKinsey o Delotte, y a lo que estamos empezando a observar en nuestra propia experiencia.

Convergencia de Roles

En los proyectos menores, una tendencia que está emergiendo es la convergencia de roles. Ahora un Product Manager puede asumir no solo sus responsabilidades tradicionales sino también las de desarrollo, testing o incluso despliegue. Un UX puede crear un interfaz y convertirlo en código ejecutable, un front puede desarrollar un back y un back lanzar despliegues.

En estos proyectos las barreras entre estos roles tradicionales se están desvaneciendo y los equipos de producto pueden ser más flexibles y ágiles. En proyectos más complejos la especialización sigue siendo un valor que la IA se encarga ampliar y extender. Los ingenieros dejan de ser especialistas y se transforman en gestores de equipos formados por técnicos humanos y agentes de IA.

Cambio de Mentalidad

Sin duda es la clave para adoptar esta transformación y principal barrera para no adoptarla. Muchos roles especialistas como product managers, arquitectos, ingenieros de software, testers o DevOps se ven amenazados por la IA pero, paradójicamente, adoptarla les hace mejores en su especialidad extiende sus capacidades a otras especialidades.

Esta expansión de capacidades requiere que el ingeniero disponga de una visión global del proyecto, de la organización y de su metodología. Aquellos especialistas sin una visión global son los que tienen un mayor riesgo de desplazamiento por IA.

En los equipos AI-Native Engineering, todos los miembros del equipo deben tener una visión global del proyecto y su contexto, de los estándares y buenas prácticas a aplicar tanto en su rol como en el de sus compañeros.

Para reducir esa carga coginitiva es importante que los equipos trabajen no solo con herramientas de IA sino con procesos pensados para ello que incorporen estándares comunes compartidos por humanos e IA. De nuevo hablamos de Ingeniería de Contexto.

Seguridad y Calidad del Código

La velocidad nunca ha debido medirse en líneas de código pero, en este momento, menos que nunca. El volumen de líneas de código crece exponencialmente y eso hace que las herramientas tradicionales de seguridad y calidad no sean suficientes.

Por suerte, también en esas tareas se puede emplear la IA. Calidad y Seguridad deben formar parte de este cambio de los procesos, de otra forma no podrán mantener el ritmo.

En este punto entra también la Ingeniería de Contexto: ser capaces de inyectar a los agentes de IA los requisitos de calidad y seguridad permite generar productos de calidad y seguro desde el diseño.

Gestión de Expectativas Organizacionales

Todavía hay inmadurez en el mercado y, aunque las experiencias son muy positivas, no es posible garantizar resultados consistentes en todas las tecnologías, organizaciones y tipos de proyectos.

De nuevo, contar con contextos creados para los agentes de IA es clave para lograr resultados consistentes. Sin estos contextos el resultado depende mucho más de la experiencia del técnico o experto de dominio coordinando estos agentes.

¿Por qué nos enfrentamos a una Transformación Diferente?

Habiendo vivido la transición de mainframe a cliente-servidor, de waterfall a Agile, de monolitos a microservicios, de on-premise a cloud, puedo afirmar con certeza que esta transformación es cualitativamente diferente.

1. Velocidad de Adopción Sin Precedentes

Agile tardó más de una década: en ser adoptado masivamente desde su Manifesto de 2001.

DevOps tardó años en madurar desde sus inicios a mediados de los 2000.

La Ingeniería de Plataformas todavía no se aplica en muchas organizaciones.

El uso de IA en el SDLC ha nacido recientemente y crecido exponencialmente. Según estudios, el 92% de desarrolladores basados en EE.UU. ya usan herramientas de codificación con IA. GitHub Copilot tiene más de un millón de desarrolladores activados y más de 20,000 organizaciones adoptantes.

2. Democratización Radical

Anteriormente, cada fase de evolución hacía el desarrollo más accesible, pero siempre requería conocimiento técnico sustancial.

Ahora, por primera vez, expertos de dominio sin formación en programación pueden crear software funcional. No es una hipótesis sino una observación real.

Expertos de dominio que en el pasado han trabajado con plataformas low-code están dando el salto sin formación a un entorno en el que no tienen las restricciones del pasado y saltan de arrastrar figuras a escribir textos. Esto no significa que todos los empleados de una compañía deban hacerlo -como tampoco todos eran capaces de usar low-code- ni que puedan hacer cualquier tipo de proyecto pero es un hecho que sus capacidades se multiplican.

3. Autonomía Emergente

Hasta ahora, las herramientas siempre requirieron dirección humana continua.

Los agentes autónomos como Devin o Blitzy pueden tomar un issue de Jira o GitHub, planificar un enfoque, implementar una solución, probarla y crear un pull request. Todo ello sin intervención humana continua.

4. Cambio Económico Fundamental

El coste de crear software está cayendo dramáticamente. Esto tiene implicaciones que estamos empezando a observar:

- ¿Qué pasará con el mercado de SaaS cuando “build” es más barato que “buy”?

- ¿Cómo cambia el outsourcing cuando puedes tener “equipos” de agentes de IA a fracción del coste?

- ¿Qué significa para estrategias de producto cuando prototipar es casi gratis?

5. Convergencia de Fases del SDLC

Las fases tradicionales —requisitos, arquitectura, diseño, desarrollo, testing, deployment, operación— cada vez están más entrelazadas y pueden ocurrir casi simultáneamente. Además, en entornos maduros pueden ser operadas por agentes coordinados y supervisados por humanos. ¿Qué cargo damos al nuevo rol de esas personas?

6. Aprendizaje continuo

Si siempre he creído en el “long-life learning”, ahora es más necesario que nunca. Podemos esquivar la realidad durante un tiempo pero no es una estrategia sostenible.

En este momento, todas las organizaciones están tratando de aprender a adoptar estas nuevas formas de trabajo lo que abre la oportunidad a conversaciones sinceras en las que compartir experiencias y aprendizajes, éxitos y fracasos que todos estamos viviendo.

Conclusión: El Camino por Recorrer

Si volvemos mentalmente al mundo en el que arranqué hemos recorrido un largo camino con multitud de cambios pero siempre había unos fundamentos constantes.

Pero lo más excitante es que ahora no sólo estamos automatizando lo que hacíamos, sino cambiando fundamentalmente lo que hacemos y cómo lo hacemos.

Esta revolución afecta a:

- Velocidad: De meses a días, de días a horas.

- Accesibilidad: De especialistas a expertos de dominio.

- Autonomía: De herramientas dirigidas a agentes colaborativos.

- Economía: De capital-intensivo a costo marginal cercano a cero.

- Cambio fundamental en los procesos: Con la convergencia de fases del SDLC.

Para el líder de la transformación, el gestor de productos digitales, el responsable de ingeniería, esto representa simultáneamente una oportunidad y un reto:

La oportunidad:

- Diseñar no sólo funcionalidades, sino flujos colaborativos humano-IA.

- Convertir en realidad la promesa del producto digital con velocidad, calidad y adaptabilidad sin precedentes

- Transformar la forma en que nos relacionamos con los usuarios dándoles mayor autonomía para centrarnos en lo que importa.

- Posicionarse como pioneros de la transformación AI-Native Engineering

El reto:

- Gestionar la transición organizacional sin perder estabilidad operativa.

- Desarrollar nuevas competencias en equipos existentes

- Asegurar gobernanza y calidad en un mundo más autónomo

- Liderar el cambio cultural necesario mientras se entregan resultados de negocio

No se trata sólo de cuánto código escribimos, sino de qué valor entregamos y cómo nos adaptamos al cambio constante para seguir siendo relevantes en el mercado. El futuro de la Ingenieria del Software es AI-Native Engineering. Y ese futuro ya está aquí.

Temas en los que profundizar

El tema de este post es extenso y apasionante por lo que acabo con la sensación de superficialidad. Algunos puntos en los que me gustaría profundizar son:

- Context Engineering: la nueva competencia crítica para inyectar en la IA el conocimiento del necesario para aplicarla de forma efectia en el SDLC.

- El impacto en el mercado Low-code y SaaS, ¿qué impacto tendrá en estos modelos que el “total cost of ownership” (TCO) se vea reducido drásticamente con IA-native engineering?

- El nuevo SDLC cómo son los nuevos procesos que nos permitirán mejorar radicalmente la calidad y velocidad de entrega logrando la hiperagilidad prometida.

- Competencias cómo evolucionan las competencias en el mundo de la IA-Native Engineering.

- Empresas que están liderando el cambio y las que lo están habilitando.

Referencias

- 1. McKinsey & Company (Febrero 2025). “How an AI-enabled software product development life cycle will fuel innovation.”

- 2. Bain & Company (2024). “State of the Art of Agentic AI Transformation.”

- 3. Deloitte Insights (2025). “Autonomous generative AI agents: Under development.”

- 5. Broadcom (2024). “Mainframe and Digital Transformation: Are You Driving Better Business Outcomes?“

- 6. unite.ai (Junio 2025). “Cursor AI alcanza una valoración de 9.9 millones de dólares con una recaudación masiva de 900 millones.** (2024).“

- 7. parentesis.media (Julio 2025). “Cognition se queda con Windsurf tras un fin de semana de fichajes, ofertas fallidas y cifras millonarias.”

2 + 2 = 5

Os dejo esta pequeña reflexión final: 2 + 2 = 5. Una crítica de Radiohead que cada uno podemos interpretar de forma diferente y espero escuchar muy pronto en directo.

Posts relacionados

Transformación Digital: más allá de la tecnología

En la Transformación Digital es más importante el propósito y la cultura que la propia tecnología.

PROTOPÍA: vayan familiarizándose con el término

> "Vamos a esquivar lo de la DISTOPÍA (…) > "Vamos a esquivar lo de la DISTOPÍA (…)

CAPITALISMO BIG TECH de Evgeny Morozov

"Capitalismo Big Tech" comparte muchos de los problemas que yo describo en "El fin de la INERCIA" pero no la aproximación a los mismos ya que su autor parte ...

Todas las opiniones expresadas en este blog son personales y en nada representan las de ninguna empresa u organización con la que colabore.